Explainable AI là gì

Explainable AI là tập trung vào phát triển quy trình, phương pháp để con người có thể hiểu và tin tưởng vào các kết quả được tạo ra bởi các thuật toán học máy.

Explainable AI cũng có thể hiểu là các hệ thống AI không chỉ có khả năng thực hiện một tác vụ với độ chính xác cao mà còn có khả năng giải thích một cách rõ ràng và minh bạch về các quyết định, dự đoán hoặc hành động mà chúng thực hiện.

Để hiểu rõ bản chất của XAI, cần phải đặt nó trong sự tương phản trực tiếp với khái niệm AI “hộp đen” (black-box AI).

Một hệ thống AI hộp đen được định nghĩa là một hệ thống độc lập có khả năng đưa ra quyết định mà không cần giải thích cách thức để đạt được những quyết định đó.

Các mô hình học sâu và mạng nơ-ron phức tạp là những ví dụ điển hình của AI hộp đen.

Chúng có thể học được các mẫu và mối tương quan cực kỳ tinh vi từ dữ liệu, nhưng quá trình suy luận nội tại của chúng lại là một mê cung các phép tính toán học mà con người không thể trực tiếp truy vết hay hiểu được.

Ngược lại, XAI hướng tới xây dựng các mô hình “hộp trắng” (white-box) hoặc “hộp kính” (glass-box), nơi logic bên trong có thể được con người kiểm tra và thấu hiểu.

Vai trò của Explainable AI

Xây dựng niềm tin và sự chấp nhận

Niềm tin chính là nền tảng để bất kỳ công nghệ nào được áp dụng thành công.

Con người vốn có xu hướng tin tưởng vào những hệ thống mà họ có thể hiểu được và cảm thấy an tâm.

Đối với AI, nguyên tắc này càng trở nên quan trọng hơn vì các quyết định từ hệ thống AI có thể tác động mạnh mẽ đến cuộc sống cá nhân, doanh nghiệp và toàn xã hội.

Các mô hình AI truyền thống, đặc biệt là những mô hình dựa trên thuật toán phức tạp như deep learning, thường hoạt động như những “hộp đen”.

Những mô hình này có thể đưa ra kết quả cực kỳ chính xác nhưng lại không giải thích được quá trình đạt tới kết quả đó.

Thiếu minh bạch tạo ra hoài nghi và sự phản kháng từ người dùng, các bên liên quan và cơ quan quản lý.

Explainable AI giải quyết vấn đề này khi làm cho quá trình ra quyết định của hệ thống AI trở nên minh bạch và có thể hiểu được.

Khi người dùng có thể thấy những giải thích rõ ràng, dễ hiểu về lý do tại sao AI đưa ra một quyết định cụ thể, lòng tin của họ vào hệ thống sẽ tăng lên.

Minh bạch không chỉ trấn an người dùng cuối mà còn làm hài lòng các bên quan tâm như lãnh đạo doanh nghiệp, cơ quan quản lý và kiểm soát viên.

Đây là những người cần xác minh AI hoạt động công bằng và hiệu quả.

Ví dụ: Nếu bác sĩ và bệnh nhân hiểu được lý do đằng sau khuyến nghị của AI đưa ra chẳng hạn như những triệu chứng hoặc kết quả xét nghiệm nào đã ảnh hưởng đến quyết định thì họ sẽ dễ tin tưởng hướng dẫn của AI hơn và tích hợp nó vào quy trình chăm sóc.

Thông qua nuôi dưỡng niềm tin qua tính minh bạch, XAI thúc đẩy sự chấp nhận và áp dụng rộng rãi hơn các công nghệ AI.

Nó giúp phá bỏ những rào cản được tạo ra do sợ hãi hoặc hiểu lầm.

Từ đó giúp các tổ chức phát huy hết tiềm năng của AI trong việc cải thiện hiệu quả, độ chính xác và chất lượng ra quyết định.

Đảm bảo trách nhiệm giải trình và công bằng

Vai trò quan trọng thứ hai của Explainable AI nằm ở thúc đẩy trách nhiệm giải trình và tính công bằng trong các quyết định được điều khiển bởi AI.

Các hệ thống AI không phải là hoàn hảo và chúng có thể mắc sai lầm hoặc phản ánh những thiên kiến có trong dữ liệu huấn luyện.

Những vấn đề này có thể gây ra hậu quả nghiêm trọng, đặc biệt khi AI được sử dụng trong các lĩnh vực nhạy cảm như tuyển dụng, cho vay, thực thi pháp luật, hoặc chăm sóc sức khỏe.

Nếu một hệ thống tuyển dụng được hỗ trợ bởi AI vô tình ưu tiên ứng viên nam hơn ứng viên nữ do dữ liệu huấn luyện thiên kiến.

Hoặc một mô hình chấm điểm tín dụng bất công phạt những người nộp đơn từ một số khu vực địa lý nhất định mà không có lý do chính đáng.

Nếu không có khả năng giải thích, nhận diện những vấn đề này sẽ rất khó khăn khi các quyết định của hệ thống có thể chỉ đơn giản là tùy tiện hoặc không rõ ràng.

XAI cung cấp các công cụ giúp các tổ chức truy ngược các quyết định về nguyên nhân gốc rễ.

Thông qua giải thích cách các đầu vào cụ thể ảnh hưởng đến kết quả đầu ra, XAI tạo điều kiện phát hiện khi thiên kiến hoặc lỗi đang lẻn vào hệ thống.

Khả năng này rất quan trọng để xác định trách nhiệm của các bên đúng đắn dù đó là các nhà khoa học dữ liệu đã xây dựng mô hình, các tổ chức triển khai nó, hay các cơ quan quản lý giám sát việc sử dụng.

Hơn nữa, XAI hỗ trợ triển khai AI một cách đạo đức khi tạo điều kiện giám sát liên tục và sửa chữa những thiên kiến có hại.

Các tổ chức có thể sử dụng khả năng giải thích để đo lường xem liệu mô hình của họ có đối xử công bằng với các nhóm khác nhau hay không và hành động khi phát hiện sự chênh lệch.

Quá trình này cần thiết để duy trì niềm tin của công chúng và tuân thủ các tiêu chuẩn pháp lý liên quan đến phân biệt đối xử và công bằng.

Đáp ứng yêu cầu pháp lý và tuân thủ

Trên khắp thế giới, các khung pháp lý mới đang xuất hiện để quản lý việc sử dụng AI.

Một trong những quy định đáng chú ý nhất là Quy định bảo vệ dữ liệu chung (GDPR) của Liên minh châu Âu, bao gồm “quyền được giải thích” đối với các quyết định được đưa ra bởi hệ thống tự động.

Gần đây hơn, EU đã đề xuất Đạo luật AI, thiết lập các quy tắc nghiêm ngặt cho những hệ thống AI được phân loại là “rủi ro cao”.

Những quy định này đòi hỏi mức độ minh bạch và trách nhiệm giải trình cao từ các hệ thống AI.

Các tổ chức triển khai AI phải có khả năng chứng minh cách mô hình của họ đưa ra quyết định, đặc biệt khi những quyết định đó tác động đáng kể đến cá nhân hoặc xã hội.

Explainable AI không còn là tùy chọn nữa mà nó đã trở thành công cụ thiết yếu để các công ty chứng minh sự tuân thủ với những yêu cầu pháp lý này.

Nếu không có XAI, khám phá cách một hệ thống AI hoạt động bên trong sẽ rất khó khăn.

Ví dụ: nếu một AI từ chối cho ai đó vay tiền hoặc quyết định về phương pháp điều trị y khoa, các quy định thường yêu cầu giải thích rõ ràng về quyết định đó.

XAI cung cấp điều này thông qua tiết lộ những yếu tố nào đã ảnh hưởng đến kết quả đầu ra và chúng góp phần như thế nào vào kết quả cuối cùng.

Không tuân thủ quy tắc có thể dẫn đến các hình phạt pháp lý, mất uy tín và sự tin tưởng giảm sút từ người dùng.

Do đó, các tổ chức triển khai hệ thống AI phải tích hợp các phương pháp giải thích từ ban đầu để điều hướng qua những luật lệ đang phát triển và bảo vệ mình khỏi rủi ro quy định.

Cải tiến và gỡ lỗi mô hình AI

Đối với các nhà khoa học dữ liệu và kỹ sư AI, khả năng giải thích là một kho báu thông tin chi tiết về cách một mô hình hoạt động.

XAI giúp họ hiểu tại sao mô hình đưa ra những dự đoán nhất định, xác định điểm yếu, phát hiện các mối tương quan sai lệch và gỡ lỗi các vấn đề.

Hãy xem xét một mô hình phân loại hình ảnh y khoa đạt độ chính xác cao một cách đáng ngạc nhiên.

Thoạt nhìn, điều này có vẻ như một thành công.

Tuy nhiên, sử dụng kỹ thuật XAI có thể tiết lộ rằng mô hình thực sự không phát hiện các đặc điểm bệnh lý.

Thay vào đó, nó có thể đang dựa vào những dấu hiệu không liên quan chẳng hạn như các ký hiệu trên X-quang do bác sĩ tạo ra để đưa ra dự đoán.

Loại tương quan giả mạo này có thể nguy hiểm vì mô hình không thể tổng quát hóa tốt với dữ liệu mới.

Qua việc làm sáng tỏ những vấn đề ẩn, khả năng giải thích giúp các nhà phát triển cải thiện chất lượng dữ liệu có thể thông qua việc loại bỏ hoặc che giấu các đặc điểm không liên quan và nâng cao độ tin cậy của mô hình.

Nó cũng hỗ trợ các nhóm tinh chỉnh kiến trúc mô hình hoặc quy trình huấn luyện khi cần thiết.

Ngoài gỡ lỗi, XAI còn thúc đẩy học tập liên tục.

Các nhà phát triển có thể theo dõi cách những thay đổi ảnh hưởng đến quá trình ra quyết định của mô hình.

Do đó đảm bảo các cải tiến không phải đánh đổi tính công bằng hoặc minh bạch.

Hỗ trợ ra quyết định và khám phá tri thức

Explainable AI vượt xa việc chỉ làm rõ các quyết định mà nó có thể giúp các chuyên gia khám phá những hiểu biết mới và xác thực kiến thức hiện có trong các lĩnh vực phức tạp như chăm sóc sức khỏe, tài chính và nghiên cứu khoa học.

Ví dụ: bác sĩ sử dụng công cụ chẩn đoán AI có thể thấy những triệu chứng hoặc kết quả xét nghiệm nào đã ảnh hưởng đến chẩn đoán.

Điều này không chỉ xây dựng niềm tin vào khuyến nghị của máy mà còn giúp các bác sĩ lâm sàng đánh giá lại hiểu biết và giả thuyết của chính họ về các bệnh lý.

Các nhà phân tích tài chính tận dụng XAI có thể tìm hiểu những yếu tố rủi ro chưa được biết đến trước đây tác động đến quyết định đầu tư.

Trong khi các nhà nghiên cứu có thể xác định những mối quan hệ nhân quả mới lạ trong dữ liệu thực nghiệm thông qua các mô hình có thể giải thích được.

Thông qua tiết lộ những yếu tố mà hệ thống AI coi là quan trọng, XAI trở thành một công cụ mạnh mẽ cho việc khám phá và học tập.

Nó thúc đẩy sự hợp tác giữa các chuyên gia con người và máy móc, nơi cả hai đóng góp những thế mạnh độc đáo.

Con người cung cấp kiến thức chuyên môn và trực giác, trong khi AI đưa ra các mẫu hình và liên kết dựa trên dữ liệu.

Quá trình hợp tác này có thể đẩy nhanh đổi mới, cải thiện chất lượng quyết định và thậm chí dẫn đến những bước đột phá mà không thì sẽ khó đạt được.

Ví dụ: Tại Bệnh viện, các bác sĩ đã sử dụng hệ thống AI để phân tích hình ảnh CT phổi. Khi AI chỉ ra nguy cơ ung thư, nó không chỉ đưa ra kết luận mà còn làm nổi bật các vùng đáng ngờ trên hình ảnh.

Do đó giúp bác sĩ hiểu rõ căn cứ để đưa ra quyết định điều trị phù hợp

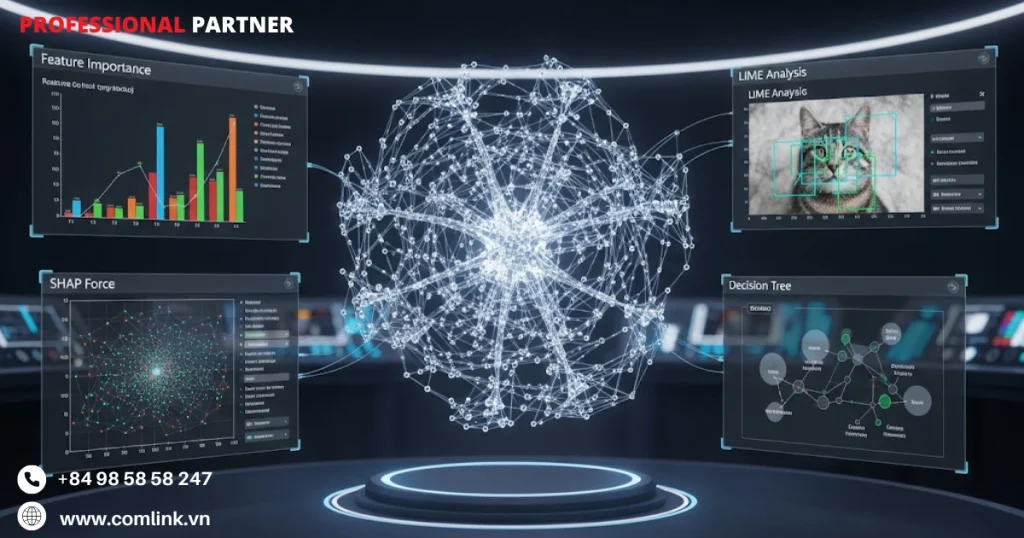

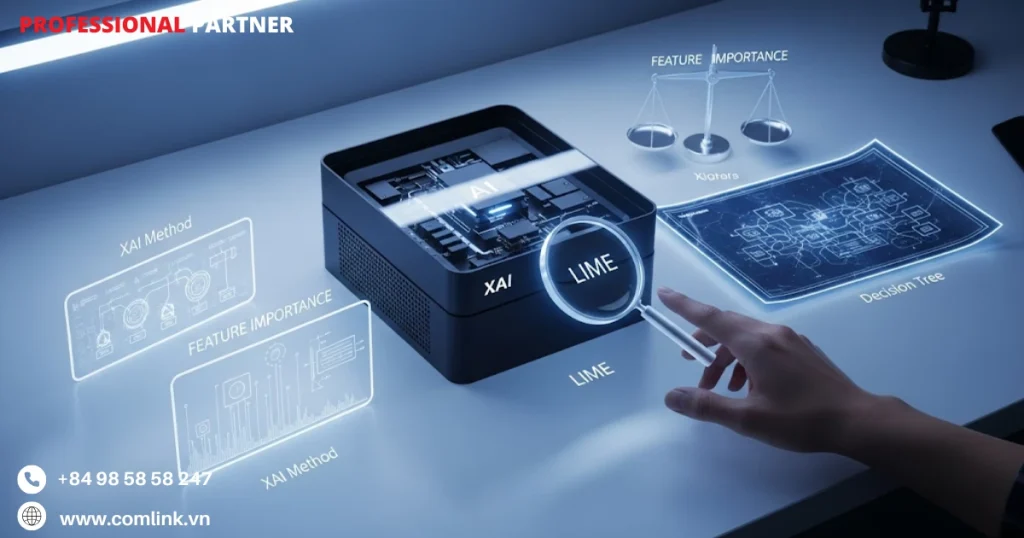

Các phương pháp XAI

Theo giai đoạn triển khai

Một trong những cách cơ bản để phân loại các kỹ thuật Explainable AI là dựa theo thời điểm chúng được áp dụng trong chu trình phát triển AI.

Điều này dẫn đến hai danh mục chính: phương pháp Nội tại và phương pháp Hậu kiểm.

Nội tại

Khả năng giải thích nội tại đề cập đến các phương pháp mà khả năng giải thích quyết định được tích hợp trực tiếp vào kiến trúc của mô hình ngay từ ban đầu.

Những mô hình như vậy vốn đã minh bạch và dễ diễn giải, thường được gọi là mô hình “hộp trắng” hoặc “hộp thủy tinh”.

Các trường hợp điển hình bao gồm hồi quy tuyến tính và cây quyết định.

Ưu điểm của phương pháp nội tại là chúng cung cấp hiểu biết rõ ràng về cách đầu vào liên quan đến đầu ra mà không cần các công cụ giải thích bổ sung.

Vì logic của mô hình đơn giản, người dùng có thể dễ dàng truy vết tại sao một dự đoán nhất định được đưa ra.

Tuy nhiên, tính minh bạch rõ ràng này đôi khi phải đánh đổi.

Những mô hình này có xu hướng đơn giản hơn và có thể không nắm bắt được các mẫu hình hoặc mối quan hệ phức tạp trong dữ liệu hiệu quả như các phương pháp tiên tiến hơn như mạng nơ-ron sâu.

Do đó cần cân bằng giữa khả năng diễn giải và độ chính xác, đặc biệt khi xử lý các tập dữ liệu phức tạp hoặc có nhiều chiều.

Ví dụ: cây quyết định được sử dụng để chấm điểm tín dụng có thể hiển thị rõ ràng những đặc điểm nào (như thu nhập hoặc lịch sử tín dụng) dẫn đến việc phê duyệt hoặc từ chối khoản vay.

Đường dẫn quyết định của mô hình rất rõ ràng, giúp cả nhà phát triển và người dùng dễ hiểu.

Hậu kiểm

Các kỹ thuật giải thích hậu kiểm được sử dụng sau khi một mô hình đã được huấn luyện thường là các mô hình “hộp đen” phức tạp như mạng nơ-ron sâu, phương pháp tổ hợp, hoặc các thuật toán tinh vi khác.

Những kỹ thuật này phân tích mô hình như một thực thể tổng thể mà không sửa đổi cấu trúc bên trong để giải thích các quyết định cá nhân hoặc hành vi chung từ bên ngoài.

Lợi ích chính của phương pháp hậu kiểm là chúng hỗ trợ các nhà phát triển tận dụng những mô hình mạnh mẽ đạt độ chính xác cao trên các vấn đề khó khăn trong khi vẫn cung cấp giải thích sau đó.

Tuy nhiên, những giải thích này đôi khi có thể gặp khó khăn với tính trung thực, nghĩa là chúng có thể không phản ánh đầy đủ lý do nội tại thực sự của mô hình.

Khoảng cách này gây ra lo ngại về độ tin cậy hoặc tính trung thực của các giải thích.

Ví dụ: sau khi huấn luyện một mạng nơ-ron tích chập (CNN) để phân loại hình ảnh y khoa, các công cụ hậu kiểm như bản đồ saliency có thể làm nổi bật các vùng của hình ảnh ảnh hưởng đến quyết định của mô hình.

Do đó cung cấp cho người dùng cái nhìn sâu sắc về các khu vực tập trung mà không thay đổi kiến trúc phức tạp của CNN.

Theo phạm vi giải thích

Một trục quan trọng khác để phân loại phương pháp Explainable AI dựa trên việc liệu giải thích có bao quát toàn bộ mô hình hay tập trung vào các dự đoán cụ thể.

Vì thế dẫn đến khả năng giải thích toàn cục và địa phương.

Toàn cục

Khả năng giải thích toàn cục cung cấp cái nhìn tổng quan về cách toàn bộ mô hình hoạt động trên tất cả các trường hợp dữ liệu.

Loại giải thích này trả lời các câu hỏi như: “Những đặc điểm nào có ảnh hưởng nhất?” hoặc “Mô hình tuân theo những mẫu hình chung nào khi đưa ra quyết định?”

Những thông tin này đặc biệt hữu ích cho các nhà phát triển trong quá trình gỡ lỗi và tinh chỉnh mô hình.

Chúng cũng có lợi cho các nhà quản lý hoặc bên liên quan muốn hiểu chiến lược rộng lớn hơn được nhúng trong hệ thống AI.

Ví dụ: trong một hệ thống phát hiện gian lận, giải thích toàn cục có thể tiết lộ rằng số tiền giao dịch và tính nhất quán về vị trí là hai đặc điểm quan trọng nhất thúc đẩy dự đoán trên tất cả các trường hợp.

Cục bộ

Khả năng giải thích cục bộ tập trung vào các dự đoán hoặc quyết định cá nhân được đưa ra bởi hệ thống AI.

Nó giải quyết các câu hỏi như: “Tại sao mô hình dự đoán kết quả này cho trường hợp cụ thể này?”

Loại giải thích này rất quan trọng đối với người dùng cuối bị ảnh hưởng trực tiếp bởi các quyết định AI như bệnh nhân nhận chẩn đoán hoặc khách hàng bị từ chối khoản vay.

Giải thích cục bộ giúp mọi người hiểu chi tiết các kết quả cụ thể.

Do đó có thể tăng niềm tin thông qua thể hiện tính minh bạch ở mức độ mà các quyết định quan trọng nhất.

Ví dụ: một hệ thống AI từ chối đơn xin vay tiền. Một giải thích cục bộ có thể xác định rằng điểm tín dụng thấp kết hợp với các khoản thanh toán trễ gần đây là những yếu tố chính ảnh hưởng đến quyết định cụ thể này.

Theo tính phụ thuộc vào mô hình

Các kỹ thuật Explainable AI cũng khác nhau dựa trên việc chúng có phụ thuộc vào chi tiết của kiến trúc mô hình cơ bản hay coi mô hình như một hộp đen.

Phụ thuộc vào mô hinh

Phương pháp phụ thuộc vào mô hình được thiết kế cho các loại kiến trúc AI cụ thể và khai thác cấu trúc nội tại để tạo ra những giải thích thường chính xác và hiệu quả hơn.

Thông qua khai thác các tham số mô hình, gradient, hoặc kích hoạt, những kỹ thuật này có thể cung cấp hiểu biết sâu sắc hơn về cách quyết định được đưa ra.

Một ứng dụng nổi tiếng là Grad-CAM (Ánh xạ Kích hoạt Lớp có Trọng số Gradient), được thiết kế riêng cho mạng nơ-ron tích chập (CNN).

Grad-CAM sử dụng gradient chảy vào các lớp tích chập để tạo ra bản đồ nhiệt làm nổi bật các vùng trong hình ảnh đầu vào có ảnh hưởng nhất đến dự đoán của mạng.

Mặc dù những phương pháp này có thể đưa ra giải thích chi tiết phù hợp chặt chẽ với cách mô hình hoạt động bên trong nhưng chúng thiếu tính tổng quát vì không thể áp dụng cho các mô hình có kiến trúc khác nhau.

Không phụ thuộc mô hình

Các kỹ thuật không phụ thuộc mô hình rất linh hoạt và có thể được sử dụng với bất kỳ mô hình hộp đen nào bất kể kiến trúc của nó.

Chúng hoạt động hoàn toàn thông qua quan sát hành vi đầu vào, đầu ra và không dựa vào chi tiết nội tại.

Thông qua coi các mô hình như hộp đen, những phương pháp này phân tích cách thay đổi đầu vào ảnh hưởng đến dự đoán đầu ra để suy ra tầm quan trọng của đặc điểm hoặc tạo ra giải thích.

LIME và SHAP là hai ứng dụng nổi bật trong danh mục này.

LIME xây dựng các mô hình đơn giản có thể diễn giải cục bộ xung quanh các dự đoán cụ thể để xấp xỉ các mô hình phức tạp và tạo ra những giải thích có thể hiểu được.

SHAP tận dụng các khái niệm lý thuyết trò chơi để phân bổ công bằng đóng góp của từng đặc điểm đối với một dự đoán trên các mẫu khác nhau.

Tính linh hoạt của các phương pháp không phụ thuộc mô hình làm cho chúng rất phổ biến trong thực tế.

Tuy nhiên vì chúng suy ra giải thích một cách gián tiếp thông qua thăm dò các mối quan hệ đầu vào, đầu ra nên đôi khi chúng có thể kém chính xác hơn so với các phương pháp đặc thù mô hình sử dụng kiến thức nội tại.

Ví dụ: Tại công ty phần mềm, khi phát triển hệ thống AI nhận dạng khuôn mặt cho ngân hàng, họ sử dụng phương pháp đặc thù mô hình (Grad-CAM) để hiển thị chính xác các vùng trên khuôn mặt mà AI tập trung phân tích.

Vì vậy giúp đảm bảo hệ thống không bị lừa bởi ảnh giả mạo hoặc các yếu tố không liên quan.

Các nguyên tắc giải thích hậu kiểm

| Tiêu chí | LIME (Local Interpretable Model-agnostic Explanations) | SHAP (SHapley Additive exPlanations) |

|---|---|---|

| Nguyên tắc cốt lõi | Xấp xỉ cục bộ mô hình hộp đen bằng một mô hình diễn giải được đơn giản. | Phân bổ công bằng sự đóng góp của mỗi đặc trưng vào dự đoán dựa trên giá trị Shapley từ lý thuyết trò chơi. |

| Loại giải thích | Chỉ cung cấp giải thích cục bộ (cho từng dự đoán riêng lẻ). | Cung cấp cả giải thích cục bộ và toàn cục (cho toàn bộ mô hình). |

| Tính phụ thuộc | Bất khả tri với mô hình (Model-Agnostic). | Có cả phiên bản bất khả tri (KernelSHAP) và phiên bản phụ thuộc mô hình (TreeSHAP, DeepSHAP). |

| Tốc độ tính toán | Thường nhanh hơn cho một dự đoán đơn lẻ vì chỉ cần lấy mẫu cục bộ. | Phiên bản bất khả tri (KernelSHAP) rất chậm. Các phiên bản tối ưu hóa (TreeSHAP) thì rất nhanh cho các mô hình tương ứng. |

| Tính ổn định | Thấp hơn. Kết quả có thể thay đổi giữa các lần chạy do lấy mẫu ngẫu nhiên. | Cao hơn. Có nền tảng lý thuyết đảm bảo tính nhất quán. |

| Nền tảng lý thuyết | Dựa trên giả định thực nghiệm về khả năng xấp xỉ cục bộ. | Dựa trên nền tảng toán học vững chắc của lý thuyết trò chơi, đảm bảo các thuộc tính tốt (ví dụ: hiệu quả, đối xứng). |

| Trường hợp sử dụng tốt nhất | Cần giải thích nhanh cho các quyết định cá nhân, ưu tiên sự đơn giản và trực quan cho người dùng không chuyên. | Cần sự giải thích đáng tin cậy, nhất quán, cả cục bộ và toàn cục; khi nền tảng lý thuyết là quan trọng (ví dụ: báo cáo tuân thủ). |

Ứng dụng của Explainable AI

Dịch vụ tài chính

Ngành tài chính luôn đi đầu trong việc ứng dụng các công nghệ trí tuệ nhân tạo, sử dụng AI để cải thiện hiệu quả, độ chính xác và khả năng ra quyết định.

Tuy nhiên, ngành này cũng phải đối mặt với những yêu cầu nghiêm ngặt nhất về tính minh bạch do tính chất nhạy cảm của dữ liệu tài chính và môi trường pháp lý.

Explainable AI (XAI) đóng vai trò quan trọng để giải quyết những thách thức này.

Chấm điểm tín dụng và phê duyệt khoản vay

Một trong những ứng dụng quan trọng nhất của AI trong tài chính là quá trình chấm điểm tín dụng và phê duyệt khoản vay.

Các mô hình AI truyền thống, đặc biệt là những mô hình phức tạp như mạng nơ-ron sâu hoặc phương pháp tổng hợp, có thể dự đoán rủi ro vỡ nợ với độ chính xác ấn tượng.

Tuy nhiên, những mô hình này thường được gọi là “hộp đen” vì chúng cung cấp rất ít thông tin về lý do tại sao một quyết định cụ thể lại được đưa ra.

Vấn đề với các mô hình hộp đen

Khi đơn xin vay của một khách hàng bị từ chối bởi mô hình như vậy, thiếu lời giải thích rõ ràng có thể dẫn đến sự thất vọng và không hài lòng.

Khách hàng tự nhiên muốn biết tại sao họ bị từ chối và họ có thể làm gì để cải thiện cơ hội trong tương lai.

Không có lý luận minh bạch, các tranh chấp và khiếu nại gia tăng sẽ làm giảm lòng tin của khách hàng.

Quan trọng hơn, từ góc độ pháp lý, sự mờ mịt này gây ra những rủi ro nghiêm trọng.

Ví dụ: tại Hoa Kỳ, Đạo luật Cơ hội Tín dụng Bình đẳng (ECOA) yêu cầu các tổ chức cho vay phải cung cấp lý do rõ ràng khi từ chối tín dụng.

Nếu không đáp ứng yêu cầu này có thể dẫn đến hậu quả pháp lý và thiệt hại uy tín của tổ chức.

Explainable AI giải quyết như thế nào

Các kỹ thuật Explainable AI như SHAP (Giải thích Cộng dồn Shapley) và LIME (Giải thích Cục bộ Bất khả tri Mô hình) đã trở thành công cụ thiết yếu cho các tổ chức tài chính trong bối cảnh này.

Những phương pháp này giúp “giải mã” các quyết định của mô hình AI thông qua phân tích đóng góp của các yếu tố khác nhau ảnh hưởng đến điểm tín dụng hoặc quyết định cho vay.

Những kỹ thuật này có thể làm nổi bật cách mà lịch sử tín dụng, mức thu nhập, tỷ lệ nợ trên thu nhập, hoặc các đơn xin vay gần đây của một người đã tác động đến đánh giá của mô hình.

Nhờ đó, các tổ chức cho vay có thể cung cấp cho khách hàng những phản hồi rõ ràng và mang tính xây dựng về lý do khoản vay bị từ chối và những lĩnh vực cụ thể họ có thể cải thiện.

Ví dụ: Một ngân hàng có thể sử dụng SHAP để giải thích cho khách hàng rằng đơn vay bị từ chối vì: lịch sử thanh toán muộn chiếm 40% ảnh hưởng, thu nhập không ổn định chiếm 35%, và tỷ lệ nợ cao chiếm 25%.

Thay vì chỉ nói “không đủ điều kiện”, ngân hàng có thể tư vấn khách hàng cải thiện lịch sử thanh toán và giảm nợ trong 6 tháng trước khi nộp đơn mới.

Tính minh bạch không chỉ giúp các tổ chức tài chính tuân thủ yêu cầu pháp lý mà còn xây dựng mối quan hệ bền vững hơn với khách hàng.

Khi người vay hiểu được cơ sở lý luận đằng sau các quyết định, họ có khả năng tin tưởng tổ chức cho vay cao hơn và nỗ lực cải thiện tình hình tài chính của mình.

Theo thời gian, điều này có thể dẫn đến việc giữ chân khách hàng tốt hơn và hình ảnh thương hiệu tích cực hơn.

Phát hiện gian lận

Phát hiện gian lận là một lĩnh vực quan trọng khác mà AI đã cách mạng hóa hoạt động trong dịch vụ tài chính.

Các hệ thống hiện đại phân tích lượng lớn dữ liệu giao dịch theo thời gian thực để xác định hoạt động đáng ngờ có thể cho thấy gian lận.

Tuy nhiên, những hệ thống này đối mặt với một thách thức đáng kể khi phải cân bằng giữa tốc độ và độ chính xác trong khi giảm thiểu các cảnh báo sai.

Thách thức của cảnh báo sai

Tỷ lệ cảnh báo sai cao các giao dịch hợp lệ bị gắn cờ là có khả năng gian lận—có thể gây rất nhiều phiền toái cho khách hàng.

Nếu việc mua sắm thông thường của khách hàng bị chặn hoặc gắn cờ vì bị nhận dạng nhầm là đáng ngờ.

Điều này không chỉ làm khách hàng bực bội mà còn gây hại cho uy tín của ngân hàng và tăng chi phí vận hành khi các nhà phân tích phải điều tra từng cảnh báo.

Vai trò của Explainable AI

Explainable AI cung cấp cho các nhà phân tích gian lận hiểu biết rõ ràng hơn về lý do tại sao những giao dịch nhất định bị gắn cờ.

Thay vì nhận được một cảnh báo đơn giản không có ngữ cảnh, các nhà phân tích có thể thấy những lời giải thích chi tiết tiết lộ logic đằng sau quyết định của mô hình.

Ví dụ: Sử dụng giá trị SHAP, một nhà phân tích có thể phát hiện rằng một giao dịch được gắn cờ là đáng ngờ vì nó liên quan đến một khoản tiền bất thường lớn (đóng góp 45% vào quyết định), xảy ra tại một địa điểm xa lạ (đóng góp 30%), và được thực hiện bằng một thiết bị mới (đóng góp 25%).

Lời giải thích đa yếu tố này giúp nhà phân tích nhanh chóng đánh giá liệu giao dịch có thực sự rủi ro hay chỉ bất thường nhưng hợp lệ.

Từ đó các nhà phân tích có thể giảm những cuộc điều tra không cần thiết do cảnh báo sai và tập trung nỗ lực vào những trường hợp thực sự cần chú ý.

Cách tiếp cận có mục tiêu cải thiện hiệu quả hoạt động và nâng cao trải nghiệm khách hàng thông qua giảm gián đoạn đối với các giao dịch hợp lệ.

Xây dựng lòng tin thông qua minh bạch

Trong cả chấm điểm tín dụng và phát hiện gian lận, Explainable AI đóng vai trò là cầu nối giữa các mô hình học máy phức tạp và sự hiểu biết của con người.

Bằng cách làm sáng tỏ cách các hệ thống AI đi đến quyết định, XAI giúp các tổ chức tài chính đáp ứng yêu cầu pháp lý đồng thời nuôi dưỡng lòng tin của khách hàng.

Hơn nữa, tính minh bạch trao quyền cho các chuyên gia tài chính đưa ra quyết định chính xác hơn.

Họ có thể xem xét kỹ lưỡng các kết quả đầu ra của AI một cách hiệu quả hơn, xác định các thiên lệch hoặc lỗi tiềm ẩn trong mô hình.

Vì vậy đảm bảo khả năng liên tục cải thiện hệ thống AI dựa trên những thông tin rõ ràng.

Nhiều ngân hàng đang bắt đầu triển khai XAI trong hệ thống phê duyệt tín dụng và phát hiện gian lận.

Với sự phát triển của fintech và yêu cầu minh bạch ngày càng cao từ khách hàng, XAI sẽ trở thành yếu tố không thể thiếu trong xây dựng hệ thống tài chính đáng tin cậy và hiệu quả.

Dịch vụ y tế

Y tế là một ngành mà các quyết định thường tác động trực tiếp đến sức khỏe và tính mạng con người.

Trong bối cảnh quan trọng như vậy, lòng tin và tính minh bạch không chỉ là điều mong muốn mà chúng là bắt buộc.

Trong khi trí tuệ nhân tạo (AI) chứa đựng tiềm năng to lớn để biến đổi chẩn đoán y khoa và đề xuất điều trị.

Tuy nhiên một trong những rào cản lớn nhất đối với khả năng áp dụng rộng rãi trong thực hành lâm sàng là thiếu sự rõ ràng về cách các hệ thống AI này đi đến kết luận.

Vì sao AI lâm sàng cần phải minh bạch

Các bác sĩ được đào tạo để đánh giá bằng chứng một cách chặt chẽ và hiểu rõ lý luận đằng sau chẩn đoán cũng như kế hoạch điều trị.

Họ khó có thể chấp nhận các khuyến nghị từ một hệ thống AI mờ mịt nếu không thể xác thực logic cơ bản.

Sự hoài nghi này có cơ sở vững chắc khi nhiều mô hình AI tiên tiếnđặc biệt là mạng học sâu hoạt động như những hộp đen, cung cấp rất ít thông tin về quá trình ra quyết định.

Thiếu khả năng giải thích không chỉ cản trở khả năng tin tưởng AI của bác sĩ mà còn làm phức tạp trách nhiệm giải trình và phê duyệt pháp lý.

Trong môi trường mà an toàn bệnh nhân là tối quan trọng, một hệ thống AI không thể biện minh cho quyết định của mình đơn giản sẽ không được tích hợp vào các quy trình chăm sóc tiêu chuẩn.

Explainable AI cung cấp con đường vượt qua rào cản này khi làm cho các quyết định AI minh bạch hơn, dễ hiểu hơn và phù hợp với lý luận lâm sàng.

Hỗ trợ chẩn đoán lâm sàng

Một trong những ứng dụng hứa hẹn nhất của AI trong y tế là dự đoán bệnh tật và các tình trạng dựa trên dữ liệu lâm sàng như kết quả xét nghiệm, tiền sử bệnh nhân và triệu chứng.

Tuy nhiên, để bác sĩ dựa vào những dự đoán này, họ cần hiểu những yếu tố nào đã tác động đến kết luận của AI.

Các kỹ thuật như LIME (Giải thích Cục bộ Bất khả tri Mô hình) và SHAP (Giải thích Cộng dồn Shapley) tạo điều kiện để thông qua khả năng làm nổi bật các đặc điểm chính có ảnh hưởng mạnh nhất đến dự đoán.

Ví dụ: nếu một mô hình AI dự đoán nguy cơ cao mắc tiểu đường cho một bệnh nhân, các công cụ XAI có thể cho thấy rằng nồng độ glucose trong máu cao, tiền sử gia đình và chỉ số BMI là những yếu tố đóng góp chính.

Tại nhiều bệnh viện lớn, hệ thống AI dự đoán nguy cơ biến chứng tim mạch cho bệnh nhân tiểu đường.

Thay vì chỉ đưa ra tỷ lệ phần trăm nguy cơ, hệ thống XAI giải thích rằng: HbA1c cao (đóng góp 35%), huyết áp tâm trương >90mmHg (đóng góp 28%), tuổi trên 60 (đóng góp 20%), và thói quen hút thuốc (đóng góp 17%).

Điều này giúp bác sĩ có thể tư vấn bệnh nhân tập trung vào những yếu tố có thể can thiệp được.

Vì vậy bác sĩ nhanh chóng nắm bắt lý luận của AI và so sánh với chuyên môn của họ.

Nó cũng trao quyền để họ xác định bất kỳ sự không nhất quán hoặc lỗi tiềm ẩn nào trong đánh giá của mô hình.

Từ đó dẫn đến những quyết định lâm sàng có thông tin tốt hơn.

Hơn nữa, nếu cung cấp cho bệnh nhân những lời giải thích rõ ràng về chẩn đoán sẽ giúp xây dựng lòng tin và khuyến khích tuân thủ các kế hoạch điều trị được khuyến nghị.

Phân tích hình ảnh y tế

Hình ảnh y tế có thể được coi là lĩnh vực trong y tế mà Explainable AI thể hiện giá trị nổi bật nhất.

Các mô hình học sâu, đặc biệt là mạng nơ-ron tích chập (CNN), đã cho thấy khả năng xuất sắc trong phân tích các hình ảnh phức tạp như X-quang, CT scan và MRI để phát hiện bất thường như khối u hoặc tổn thương.

Tuy nhiên, không có công cụ diễn giải, các bác sĩ lâm sàng khó biết liệu AI có đang tập trung vào các đặc điểm có liên quan về mặt y khoa hay bị lừa dối bởi các dữ liệu nhiễu không liên quan.

Các kỹ thuật XAI như Grad-CAM (Ánh xạ Kích hoạt Lớp Có trọng số Gradient) và LIME cho hình ảnh giải quyết điều này qua việc tạo ra “bản đồ nhiệt” trực quan làm nổi bật các vùng của hình ảnh ảnh hưởng đến quyết định của mô hình.

Những bản đồ nhiệt này giúp các bác sĩ X-quang và bệnh lý học xác thực rằng AI đang chú ý đến các đặc điểm bệnh lý quan trọng thay vì các mẫu nền không liên quan.

Ví dụ: Khi một AI gắn cờ một vùng đáng ngờ trên ảnh X-quang ngực như một khối u tiềm ẩn, bản đồ nhiệt đi kèm có thể làm sáng vùng cụ thể đó.

Do đó giúp bác sĩ X-quang xác thực hoặc đặt câu hỏi về phát hiện dựa trên chuyên môn của họ.

Lời giải thích trực quan này trở thành công cụ mạnh mẽ để kiểm chứng chéo và xây dựng niềm tin vào kết quả đầu ra của hệ thống AI.

Một số bệnh viện đa khoa đã sử dụng AI để sàng lọc ung thư phổi từ ảnh CT.

Hệ thống không chỉ đưa ra chẩn đoán mà còn tạo bản đồ nhiệt cho thấy AI đã phát hiện nốt bất thường ở thùy phổi nào, kích thước và mật độ ra sao.

Điều này giúp bác sĩ X-quang có thể quyết định nhanh chóng việc cần sinh thiết hay theo dõi định kỳ.

Tăng cường hợp tác giữa con người và AI

Explainable AI thúc đẩy môi trường hợp tác nơi các chuyên gia y tế và hệ thống AI bổ sung cho điểm mạnh của nhau.

Bác sĩ mang đến kiến thức lâm sàng sâu sắc và hiểu biết về ngữ cảnh, trong khi AI đóng góp tốc độ, tính nhất quán và khả năng phân tích bộ dữ liệu khổng lồ.

Thông qua cách làm cho các quyết định AI có thể diễn giải được, XAI tạo điều kiện cho bác sĩ xác thực khuyến nghị nhanh chóng và thực hiện điều chỉnh khi cần thiết.

Nó cũng cung cấp cơ hội cho các bác sĩ lâm sàng học hỏi từ các mẫu AI mà họ có thể chưa nhận ra trước đây.

Hơn nữa, các mô hình AI minh bạch tạo thuận lợi cho giao tiếp giữa các nhà cung cấp dịch vụ y tế và bệnh nhân.

Khi bệnh nhân hiểu cách chẩn đoán hoặc kế hoạch điều trị được xác định, họ có nhiều khả năng tin tưởng người chăm sóc và tham gia tích cực vào việc chăm sóc bản thân.

Ví dụ: Một phòng khám tim mạch sử dụng AI để phân tích điện tâm đồ (ECG).

Hệ thống không chỉ cảnh báo loạn nhịp mà còn giải thích cho bệnh nhân bằng hình ảnh trực quan: “Nhịp tim của anh chị có những điểm bất thường ở khoảng giây thứ 15-20, cho thấy tín hiệu điện từ tâm nhĩ đến tâm thất bị gián đoạn”.

Điều này giúp bệnh nhân hiểu tại sao cần theo dõi thêm và tuân thủ điều trị tốt hơn.

Pháp lý và tư pháp

Trí tuệ nhân tạo đang thâm nhập vào nhiều lĩnh vực, và các lĩnh vực pháp lý cũng như tư pháp không phải là ngoại lệ.

Tuy nhiên, đưa AI vào những lĩnh vực này đặt ra những câu hỏi sâu sắc về công bằng, đạo đức và quyền được xét xử công bằng.

Các quyết định trong lĩnh vực này có hậu quả đáng kể vì ảnh hưởng đến tự do, quyền lợi và công lý nên tính minh bạch và đáng tin cậy là tối quan trọng.

Explainable AI (XAI) nổi lên như một công cụ thiết yếu để giải quyết những mối quan ngại quan trọng này.

Vai trò của AI trong đánh giá rủi ro tư pháp

Một trong những ứng dụng gây tranh cãi nhất của AI trong tư pháp là các công cụ đánh giá rủi ro được sử dụng để dự đoán khả năng tái phạm của bị cáo.

Những dự đoán này tác động đến các quyết định về tại ngoại, tuyên án và ân xá có điều kiện.

Trong khi các mô hình AI có thể phân tích bộ dữ liệu khổng lồ để xác định các mẫu có thể thoát khỏi sự đánh giá của con người nhưng sử dụng chúng đã gây ra cuộc tranh luận đáng kể.

Một trường hợp được thảo luận rộng rãi là công cụ COMPAS (Profiling Quản lý Tội phạm Sửa chữa cho Các Biện pháp Thay thế).

Các nghiên cứu tiết lộ COMPAS thể hiện thiên lệch chủng tộc.

Nó có xu hướng đánh giá quá cao rủi ro tái phạm đối với bị cáo da đen trong khi đánh giá thấp đối với bị cáo da trắng.

Thiên lệch này đã gây ra sự phẫn nộ của công chúng và sự giám sát pháp lý, nhấn mạnh những nguy hiểm của việc dựa vào các thuật toán “hộp đen” khó hiểu mà không hiểu logic bên trong của chúng.

Ví dụ: Tưởng tượng một hệ thống AI được áp dụng để đánh giá rủi ro tái phạm trong các phiên tòa. Nếu hệ thống này đưa ra điểm số cao cho một bị cáo từ vùng nông thôn mà không giải thích rõ lý do có thể do thiếu hiểu biết về bối cảnh kinh tế-xã hội địa phương thì có thể dẫn đến quyết định không công bằng và thiếu căn cứ.

Vấn đề cốt lõi nằm ở sự mờ mịt của những hệ thống AI này.

Khi thẩm phán hoặc bị cáo nhận được điểm rủi ro mà không có bất kỳ giải thích nào về cách nó được tính toán sẽ làm suy yếu lòng tin và gây ra những mối quan ngại nghiêm trọng về công bằng và phân biệt đối xử.

Các quyết định ảnh hưởng đến quyền cơ bản phải minh bạch và có thể thách thức.

Explainable AI là yêu cầu bắt buộc

Trong bối cảnh tư pháp, Explainable AI không chỉ là điều mong muốn mà là một yêu cầu bắt buộc.

Bất kỳ quyết định được AI thúc đẩy nào được sử dụng trong tòa án đều phải minh bạch, có thể kiểm toán và giải thích được.

Như vậy phải cung cấp thông tin rõ ràng về những yếu tố nào đã tác động đến kết luận của AI và chúng được cân nhắc như thế nào.

Ví dụ: thay vì trình bày một điểm rủi ro mờ mịt duy nhất, một hệ thống XAI sẽ chỉ rõ những tiêu chí nào như tiền án, tuổi tác, loại tội danh, hoặc hành vi trong thời gian bị giam giữ đã đóng góp vào đánh giá.

Thông tin chi tiết như vậy giúp thẩm phán hiểu lý luận đằng sau khuyến nghị và xác thực rằng nó phù hợp với các tiêu chuẩn pháp lý và nguyên tắc công bằng.

Ví dụ: Một hệ thống đánh giá rủi ro tái phạm có thể giải thích điểm rủi ro 7.5/10 được tính dựa trên: tiền án bạo lực (đóng góp 40%), tuổi dưới 25 (đóng góp 25%), thiếu việc làm ổn định (đóng góp 20%), và môi trường sống bất ổn (đóng góp 15%).

Thông tin này giúp thẩm phán đưa ra quyết định tại ngoại phù hợp và có thể đề xuất các biện pháp hỗ trợ cụ thể như tư vấn việc làm hoặc hỗ trợ nhà ở.

Khả năng giải thích cũng tạo thuận lợi cho kháng cáo và xem xét lại qua việc tạo điều kiện cho bị cáo hoặc luật sư của họ thách thức hiệu quả các đánh giá do AI tạo ra.

Không có tính minh bạch sẽ dẫn đến nguy cơ duy trì các thiên lệch có hệ thống hoặc lỗi ẩn trong các thuật toán phức tạp.

Nâng cao thực hành pháp lý thông qua Explainable AI

Ngoài ra quyết định tư pháp, AI đang biến đổi các lĩnh vực khác của luật pháp, đặc biệt là luật doanh nghiệp.

Các công ty luật thường đối mặt với nhiệm vụ đáng sợ là xem xét hàng nghìn trang hợp đồng trong quá trình thẩm định hoặc kiểm tra tuân thủ.

Các hệ thống AI có thể tự động hóa phần lớn việc xem xét này thông qua khả năng gắn cờ các điều khoản gây bất lợi hoặc xác định rủi ro.

Explainable AI đóng vai trò quan trọng ở đây không chỉ qua xác định các phần hợp đồng có vấn đề mà còn giải thích tại sao những điều khoản nhất định được gắn cờ.

Một hệ thống được hỗ trợ bởi XAI có thể làm nổi bật điều khoản cạnh tranh bất thường hạn chế hoặc điều khoản trách nhiệm pháp lý có thể khiến khách hàng đối mặt với rủi ro đáng kể.

Ví dụ: Một công ty luật sử dụng AI để phân tích hợp đồng đầu tư nước ngoài. Hệ thống không chỉ cảnh báo về điều khoản “không được chuyển nhượng trong vòng 5 năm” mà còn giải thích: “Điều khoản này có thể hạn chế 85% tính linh hoạt tài chính của doanh nghiệp so với tiêu chuẩn thị trường (thông thường 2-3 năm), đặc biệt rủi ro khi doanh nghiệp cần tái cơ cấu vốn do biến động kinh tế.

Tính minh bạch đã giúp cho luật sư nhanh chóng hiểu bản chất của các vấn đề được các công cụ AI đưa ra mà không cần tin tưởng mù quáng vào kết quả đầu ra tự động.

Vì thế các nhóm pháp lý có thể tăng tốc quy trình thẩm định, giảm lỗi của con người.

Từ đó phân bổ nhiều thời gian hơn cho phân tích chiến lược và tư vấn khách hàng thay vì xem xét tài liệu lặp đi lặp lại.

Các chuyên gia dự đoán rằng đến năm 2026, Explainable AI sẽ trở thành tính năng cốt lõi của phần mềm phân tích hợp đồng, nhúng thêm khả năng diễn giải vào các giải pháp công nghệ pháp lý.

Xây dựng công bằng, tin cậy và hiệu quả

Explainable AI giải quyết ba nhu cầu quan trọng trong các ứng dụng pháp lý và tư pháp: công bằng, đáng tin cậy và hiệu quả hoạt động.

Công bằng được duy trì khi các quyết định AI đủ minh bạch để có thể giám sát và thách thức của con người.

Lòng tin phát triển khi thẩm phán, luật sư và khách hàng hiểu cách các kết luận AI được đưa ra.

Hiệu quả được cải thiện khi các chuyên gia pháp lý tận dụng các công cụ AI cung cấp lời giải thích rõ ràng thay vì phán quyết hoặc cảnh báo mờ mịt.

Hơn nữa, khả năng giải thích hỗ trợ tuân thủ các tiêu chuẩn đạo đức và yêu cầu pháp lý liên quan đến quy trình thủ tục tố tụng và không phân biệt đối xử.

Nó cũng đóng góp vào niềm tin của công chúng đối với các công nghệ mới trong các lĩnh vực nhạy cảm như tư pháp.

Lợi ích cụ thể trong hệ thống pháp luật

- Tăng cường minh bạch: Các quyết định của tòa án có căn cứ rõ ràng, giảm nghi ngờ về tính công bằng

- Cải thiện chất lượng: Luật sư có thể đưa ra lập luận chính xác hơn dựa trên phân tích AI

- Tiết kiệm thời gian: Rút ngắn thời gian nghiên cứu hồ sơ từ nhiều tuần xuống vài ngày

- Giảm sai sót: Hạn chế bỏ sót điều khoản quan trọng trong hợp đồng phức tạp

Thách thức và triển vọng

Mặc dù có tiềm năng nhưng tích hợp Explainable AI vào hệ thống pháp lý đối mặt với những thách thức.

Phát triển các lời giải thích có ý nghĩa nhưng ngắn gọn cho các thẩm phán hoặc luật sư bận rộn đòi hỏi thiết kế cẩn thận.

Đảm bảo các phương pháp XAI là phản ánh chính xác hành vi mô hình thực s không chỉ là những biện minh hợp lý mà còn là lĩnh vực nghiên cứu đang tiếp tục.

Các khung pháp lý cũng đang phát triển để theo kịp những tiến bộ công nghệ.

Các nhà hoạch định chính sách phải xác định tiêu chuẩn cho tính minh bạch và trách nhiệm giải trình trong việc ra quyết định thuật toán.

Tuy nhiên khi AI trở nên phổ biến hơn trong luật pháp và tư pháp, các tổ chức bỏ qua nhu cầu này có nguy cơ duy trì thiên lệch, làm xói mòn lòng tin và phải đối mặt với những thách thức pháp lý.

Hệ thống xe tự hành

Xe tự lái và các hệ thống tự hành khác đang là mục tiêu của đổi mới công nghệ, hứa hẹn hiện đại hóa giao thông vận tải và công nghiệp.

Tuy nhiên, an toàn vẫn là ưu tiên hàng đầu.

Trong môi trường có cược cao này, khả năng giải thích các quyết định AI không chỉ là một tính năng mà là một nhu cầu nền tảng.

Thách thức chính của xe tự hành

Xe tự lái hoạt động trong môi trường động và không thể dự đoán.

Chúng liên tục xử lý lượng lớn dữ liệu cảm biến để đưa ra các quyết định trong tích tắc như có nên phanh gấp, lái tránh chướng ngại vật bất ngờ hay chuyển làn để ngăn va chạm.

Tuy nhiên, khi một xe tự lái thực hiện những hành động như vậy, hành khách, nhà sản xuất và người điều tra cần những lời giải thích rõ ràng về lý do những quyết định đó được đưa ra đặc biệt trong trường hợp tai nạn hoặc suýt xảy ra tai nạn.

Không có khả năng truy vết và diễn giải quá trình ra quyết định của AI, trách nhiệm trở nên không rõ ràng.

Do đó sẽ tạo ra khoảng cách đáng kể trong trách nhiệm pháp lý và niềm tin của công chúng.

Ví dụ: Hãy tưởng tượng một tình huống mà một chiếc xe phanh đột ngột trên cao tốc đông đúc. Nó có đang phản ứng với người đi bộ băng qua đường? Nó có phát hiện xe khác phanh phía trước? Hay đó là cảnh báo sai do trục trặc cảm biến?

Hiểu những chi tiết này rất quan trọng để đánh giá an toàn và cải thiện hiệu suất hệ thống.

Trên đường phố Hà Nội hoặc TP.HCM với mật độ xe máy cao, một xe tự lái có thể đưa ra quyết định chuyển làn đột ngột.

Khi giải thích rằng “hệ thống phát hiện 3 xe máy đang chuẩn bị vượt từ phía sau với tốc độ 45km/h, đồng thời có xe buýt dừng đột ngột phía trước, nên quyết định chuyển sang làn bên trái an toàn hơn” sẽ giúp hành khách hiểu và tin tưởng vào quyết định này.

Explainable AI hỗ trợ như thế nào

Explainable AI cung cấp lời giải thích thời gian thực về hành vi của hệ thống tự hành, cung cấp hiểu biết về cơ sở lý luận đằng sau mỗi hành động.

Khả năng này mang lại lợi ích cho nhiều bên liên quan:

Kỹ thuật và gỡ lỗi

Đối với các kỹ sư phát triển hệ thống tự hành, các công cụ XAI có giá trị vô cùng trong việc gỡ lỗi các mô hình phức tạp.

Thông qua tiết lộ những gì hệ thống “nhìn thấy” và tại sao nó phản ứng theo những cách cụ thể, các nhà phát triển có thể xác định lỗi, tinh chỉnh thuật toán và nâng cao độ tin cậy.

Ví dụ: bản đồ chú ý công cụ trực quan làm nổi bật những phần nào của môi trường mà AI tập trung vào có thể cho thấy rằng hệ thống đã phát hiện người đi bộ bước lên đường hoặc nhận thấy xe phía trước đột ngột giảm tốc.

Phản hồi trực quan này giúp kỹ sư đảm bảo rằng AI đang phản ứng phù hợp với các kích thích liên quan thay vì nhiễu không liên quan.

Ví dụ: Một đội phát triển xe tự lái có thể sử dụng bản đồ chú ý để phân tích tại sao xe lại phanh khi gặp “ma trận” (bóng cây, vệt nước) trên đường.

Bản đồ có thể cho thấy hệ thống nhầm lẫn bóng cây với vật cản, giúp kỹ sư điều chỉnh thuật toán nhận dạng để phù hợp với điều kiện ánh sáng nhiệt đới.

Tuân thủ quy định và chứng nhận an toàn

Các cơ quan quản lý yêu cầu bằng chứng hệ thống tự hành đáp ứng các tiêu chuẩn an toàn nghiêm ngặt trước khi chúng có thể được phê duyệt sử dụng công cộng.

XAI tạo điều kiện cho các nhà sản xuất chứng minh sự tuân thủ thông qua cung cấp bằng chứng minh bạch về cách các quyết định được đưa ra.

Những lời giải thích rõ ràng giúp các cơ quan quản lý hiểu hành vi của AI trong các điều kiện khác nhau.

Từ đó đánh giá chiến lược quản lý rủi ro và xác thực rằng các giao thức an toàn được tuân theo một cách nhất quán.

Xây dựng lòng tin của hành khách

Để hành khách cảm thấy thoải mái khi giao phó tính mạng cho xe tự lái, họ phải tin tưởng vào công nghệ.

XAI thúc đẩy lòng tin này khi cung cấp những lời giải thích dễ hiểu về hành vi của xe.

Khi hành khách nhận được thông tin về lý do xe của họ thực hiện những hành động nhất định như giảm tốc vì có người đi xe đạp phía trước họ có được niềm tin vào sự tin cậy của hệ thống.

Ví dụ: Màn hình trong xe có thể hiển thị: “Đang giảm tốc – Phát hiện học sinh băng qua đường 50m phía trước” hoặc “Chuyển làn trái – Xe tải phía trước dừng đột ngột, làn bên trái an toàn”.

Những thông báo này giúp hành khách hiểu và cảm thấy an tâm thay vì lo lắng về những động tác bất ngờ của xe.

Khả năng giải thích trong hành động

Một ứng dụng thực tế của XAI trong xe tự lái liên quan đến bản đồ chú ý.

Những bản đồ này hình dung đầu vào cảm biến và làm nổi bật các đối tượng hoặc vùng đã tác động đến một quyết định.

Ví dụ: nếu người đi bộ bất ngờ băng qua đường, bản đồ chú ý sẽ chiếu sáng vị trí của người đó trên hình ảnh đường.

Vì vậy không chỉ giúp các kỹ sư mà còn giúp những người điều tra an toàn xác thực rằng AI đã xác định đúng các mối nguy hiểm và phản ứng phù hợp.

Nó giúp phân biệt giữa phản ứng phù hợp và lỗi hệ thống.

Các kỹ thuật giải thích khác có thể cung cấp lý luận nhân quả, cho thấy cách nhiều yếu tố như điều kiện thời tiết, dòng giao thông hoặc đầu vào cảm biến kết hợp để kích hoạt các thao tác cụ thể.

Ví dụ: Trong một ngã tư phức tạp, xe tự lái quyết định dừng lại thay vì rẽ phải. Hệ thống XAI giải thích: “Phát hiện xe máy từ phía trái (60% ảnh hưởng), đèn vàng nhấp nháy (25% ảnh hưởng), và mặt đường ướt giảm ma sát (15% ảnh hưởng) – quyết định dừng an toàn nhất.”

Thông tin này giúp cả hành khách và cơ quan điều tra hiểu rõ logic quyết định.

Có thể bạn quan tâm

Liên hệ

Địa chỉ

Tầng 3 Toà nhà VNCC

243A Đê La Thành Str

Q. Đống Đa-TP. Hà Nội

info@comlink.com.vn

Phone

+84 98 58 58 247